Публикуем обзор на краулер Netpeak Spider и подробную инструкцию по работе с ним.

Содержание:

- Установка

- Основные настройки сканирования

- Параметры

- Запуск сканирования

- Работа с результатами сканирования и отчётами

- Сохранение проекта и выгрузка данных

- Встроенные инструменты Netpeak Spider

- Выводы

Netpeak Spider — программа, которая помогает провести детальный аудит сайта и найти проблемы, связанные с внутренней оптимизацией. Краулер также снабжен различными инструментами, которые способны облегчить и автоматизировать работу специалистов из разных сфер, включая SEO, контент-маркетинг, линкбилдинг, PPC и продажи.

Благодаря высокой производительности и удобному юзабилити вы сможете получить все нужные данные в кратчайшие сроки, даже работая с сайтами-гигантами.

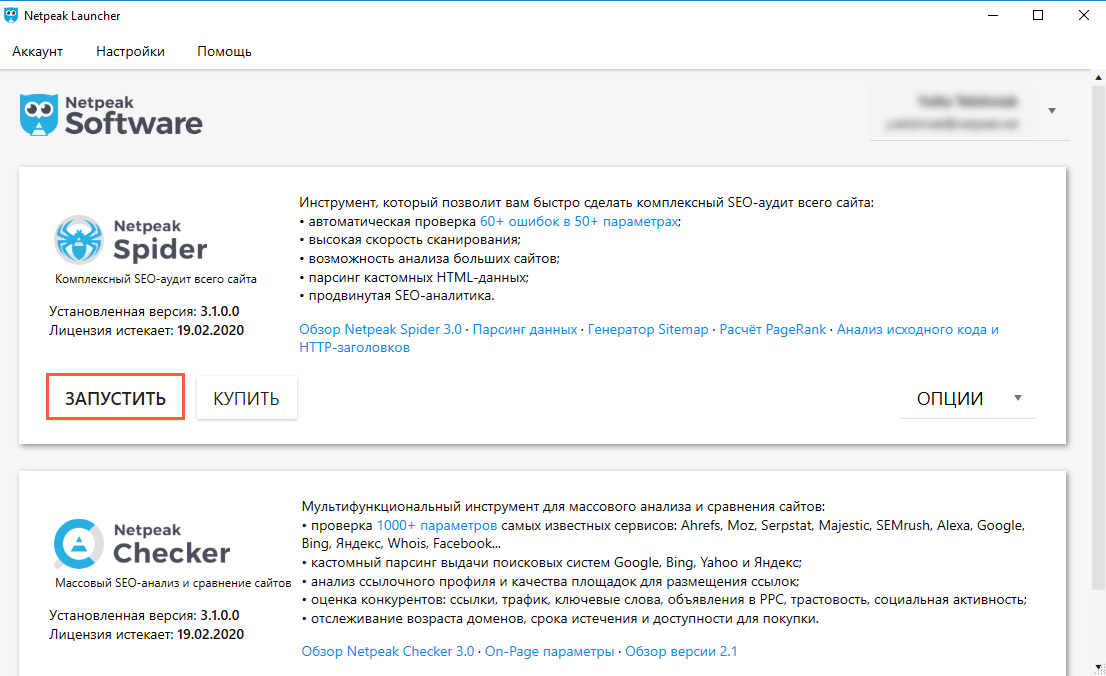

Установка

Программа предусматривает бесплатный 14-дневный пробный период, за время которого вы успеете ознакомиться со всеми её возможностями и решить, стоит ли совершать покупку.

Чтобы воспользоваться пробным периодом, вам необходимо:

- Зарегистрировать аккаунт на сайте Netpeak Software.

- Скачать и установить программу для управления продуктами Netpeak Launcher и авторизоваться в нём.

- Установить Netpeak Spider прямо из Launcher.

Несколько несложных манипуляций, и программа уже на вашем компьютере.

Настройки сканирования

После запуска Netpeak Spider перед вами откроется основное окно программы.

Вы можете сразу запустить сканирование сайта, но все же лучше разобраться в настройках, чтобы максимально кастомизировать их под свои нужды.

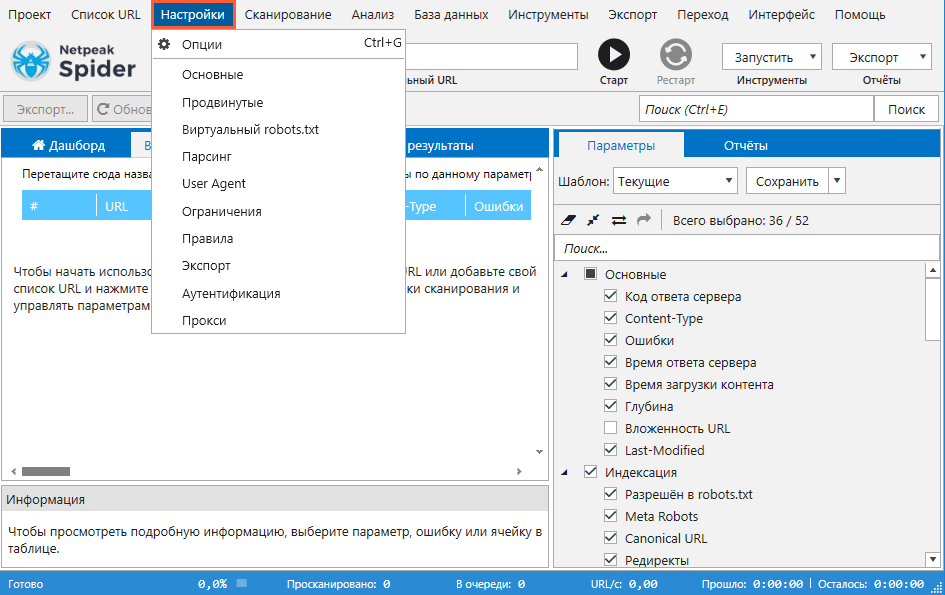

В окне с настройками программы вы найдете 10 вкладок, каждую из которых рассмотрим по порядку. На 7 из них вы можете выбрать готовые шаблоны настроек, либо же создать собственные.

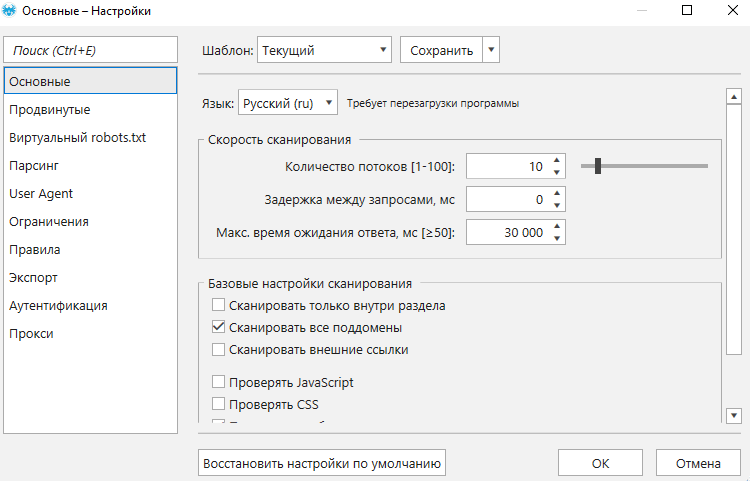

Основные настройки

Здесь вы можете менять язык интерфейса, регулировать скорость сканирования и управлять базовыми настройками сканирования. Настраивая скорость сканирования, будьте аккуратны, так как чем больше потоков, тем больше нагрузка на сканируемый сайт.

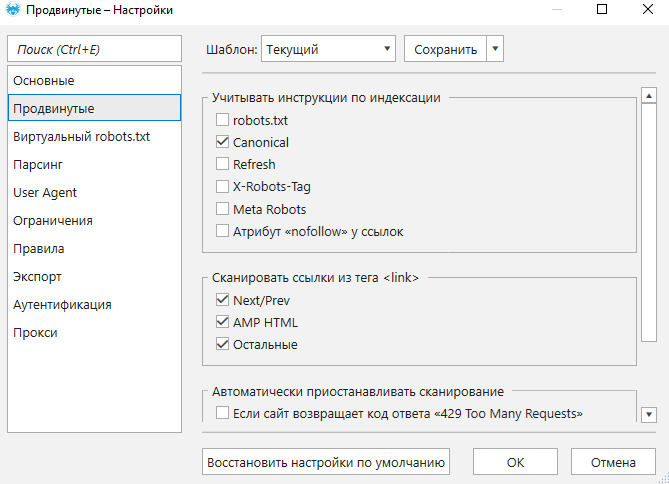

Продвинутые настройки

На этой вкладке настраивается учет инструкций по индексации, сканирование ссылок из тега, а также определяются условия, при которых сканирование будет остановлено автоматически.

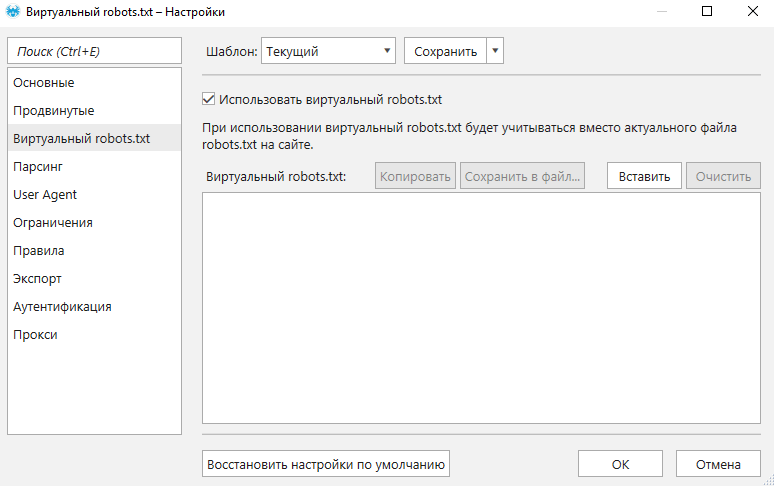

Виртуальный robots.txt

Это специальная встроенная функция, с помощью которой вы можете тестировать новый или обновлённый файл robots.txt и проверять, как сайт может быть воспринят роботами поисковых систем.

Виртуальный robots.txt

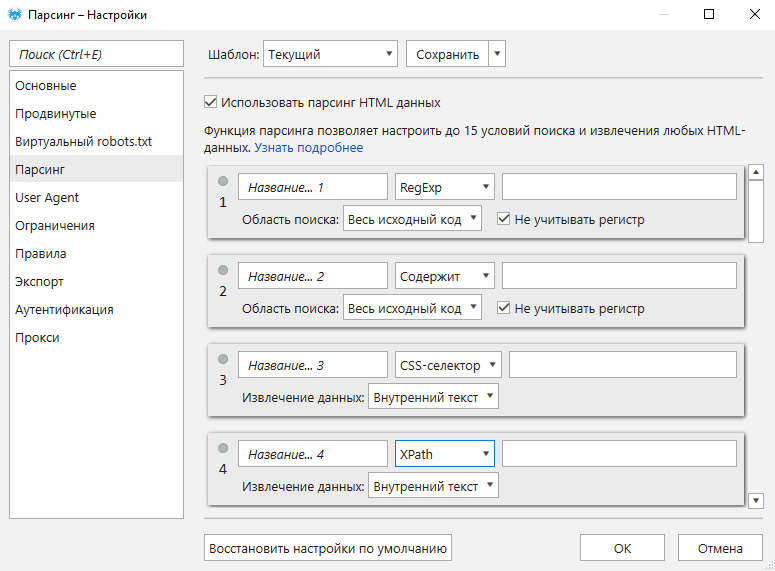

Парсинг

Здесь можно настроить до 15 потоков парсинга (извлечения данных) и собирать любые данные, указанные в тексте или HTML-коде страницы. Функция применяется, например, для проверки наличия кода аналитики и микроразметки, а также извлечения разного рода информации, включая почти любые контактные данные, параметры товаров и прочее. В настройках доступно 4 режима парсинга: «Содержит», «RegExp», «CSS-селектор» и «XPath».

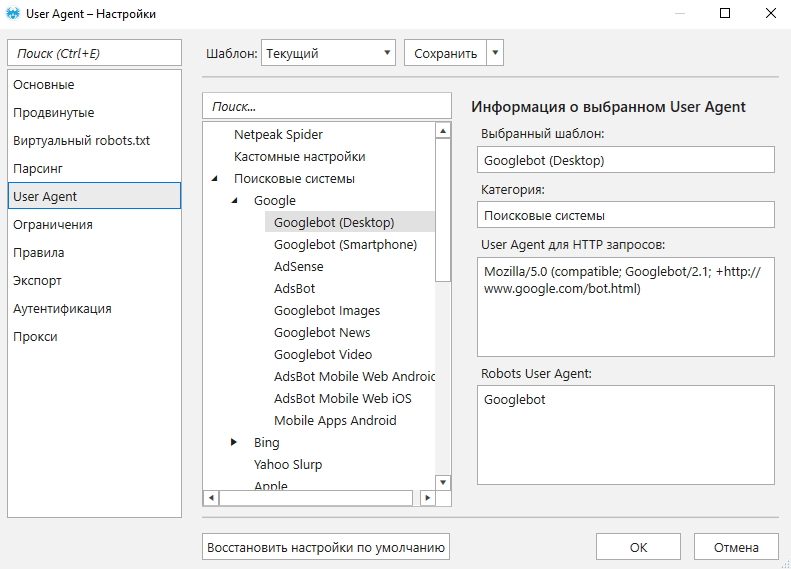

User Agent

Меняя User Agent, вы можете тестировать доступность сайта для роботов разных поисковых систем и для разных браузеров. Также с помощью этой настройки можно тестировать контент, который отдаёт сайт для мобильных устройств.

User Agent

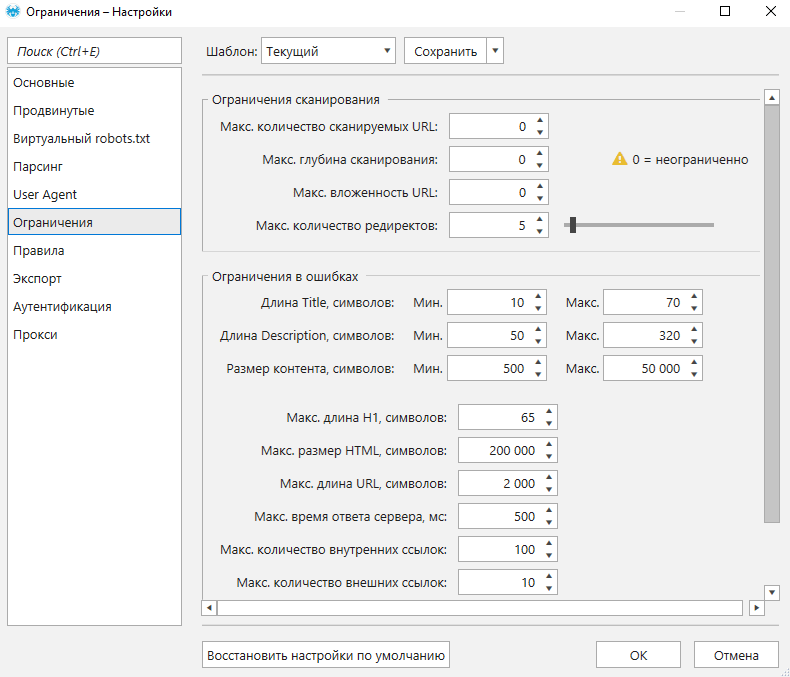

Ограничения

С помощью этих настроек вы сами определяете лимиты сканирования и задаете ограничения для определения тех или иных значений как ошибочных. Установленные на этой вкладке настройки будут учитываться при формировании отчётов на боковой панели.

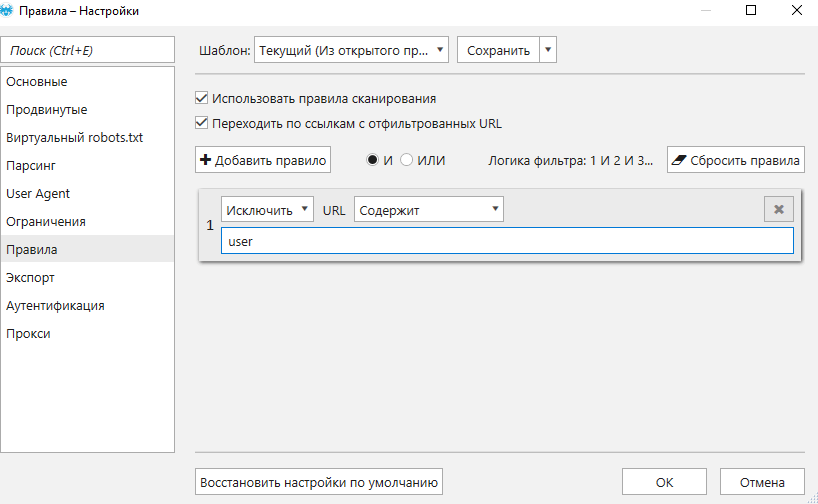

Правила

Здесь добавляются правила, с помощью которых список сканируемых страниц можно ограничить лишь определёнными условиями. Например, сканировать страницы только определённой категории, или соответствующие регулярному выражению, или только страницы товаров и пр.

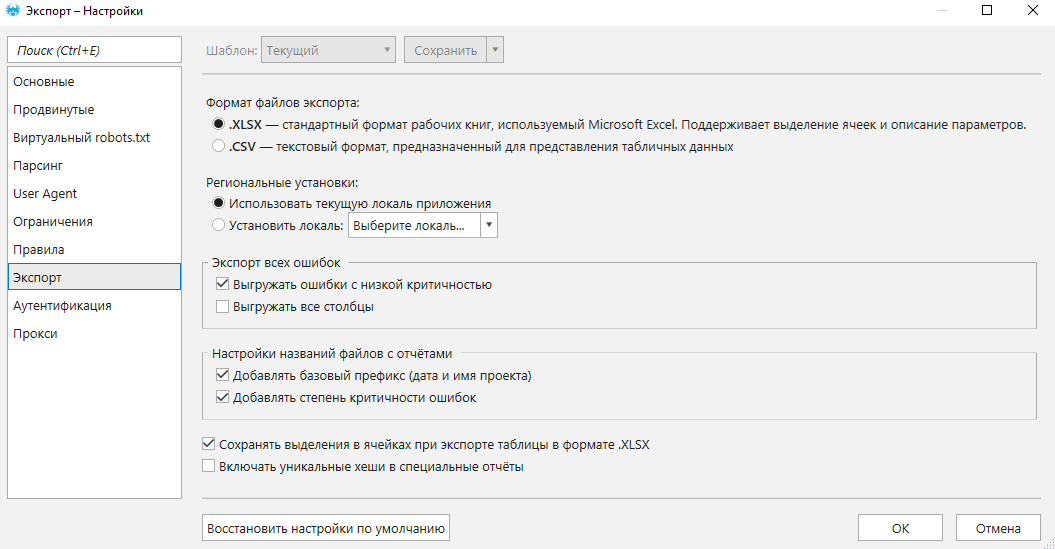

Экспорт

Здесь вы можете выбрать формат отчетов и задать настройки, которые будут учитываться при сохранении и выгрузке данных из программы.

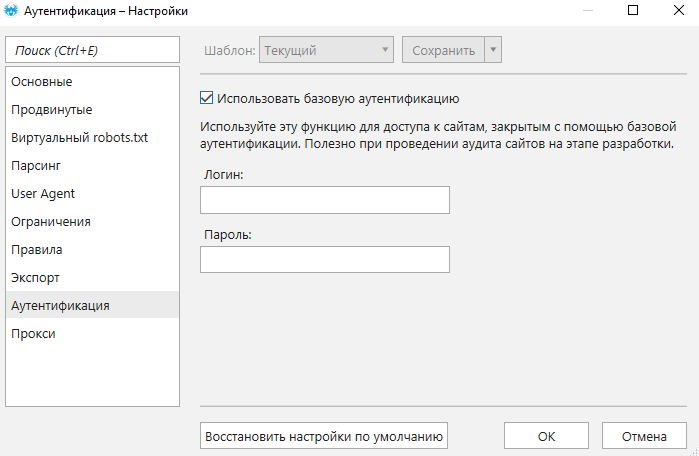

Аутентификация

Данная настройка пригодится в случае, если вам нужно прокраулить сайт, который, к примеру, находится на стадии закрытого тестирования, а доступ к нему ограничен с помощью базовой аутентификации (логин и пароль включаются в состав запроса к серверу).

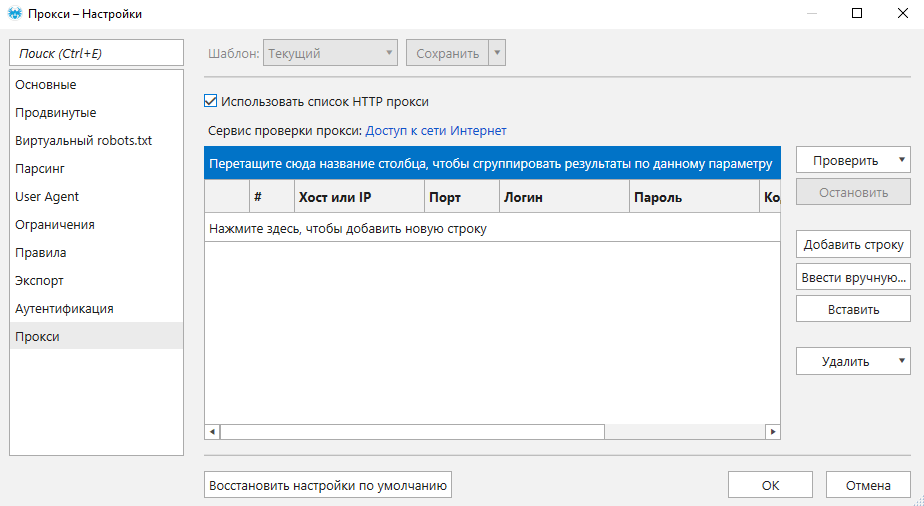

Прокси

На этой вкладке вы можете добавлять и проверять списки прокси-серверов, которые будут использоваться при сканировании сайта. Так вы можете тестировать сайт, используя разные локации для обхода ограничений сканирования системой безопасности сайтов.

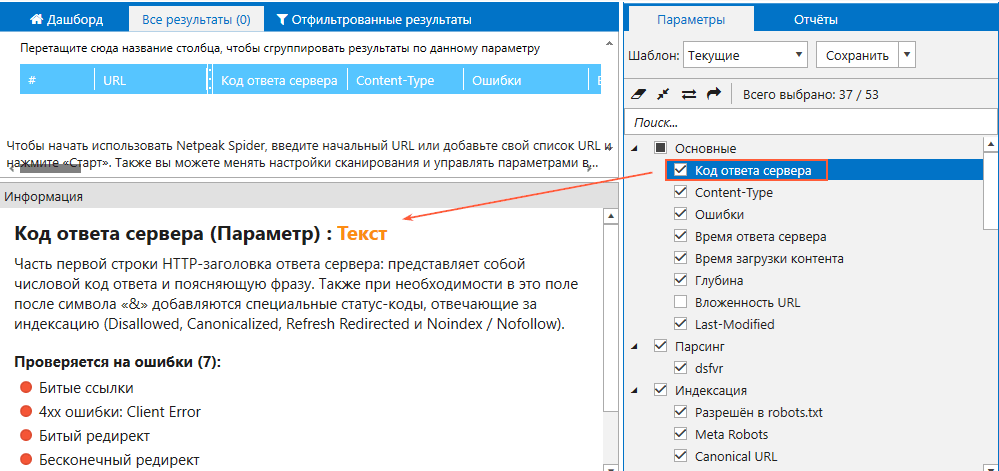

Параметры

Перейдем к вкладке «Параметры» на боковой панели, где можно указать те параметры, которые программа будет извлекать в ходе сканирования.

Всего доступно 54 параметра, объединенных в несколько групп:

- Основные. Здесь указываются базовые типы данных для анализа, такие как URL, код ответа сервера, Content-Type и т.д. Проверяется на 8 ошибок.

- Парсинг. Содержит перечень данных для извлечения, заданных в настройках парсинга.

- Индексация. Содержит параметры, которые влияют на индексируемость сайта и страниц: инструкции из файла robots.txt, Meta-Robots, X-Robots-Tag, тега Canonical и пр. Проверяется на 16 ошибок.

- Ссылки. Включает в себя параметры, отвечающие за проверку ссылочных связей: входящие и исходящие ссылки, внутренний PageRank. Проверяется на 10 ошибок.

- Head теги. Содержит параметры, соответствующие тегам в блоке страниц: Title, Description и т.д. Проверяется на 13 ошибок.

- Контент. Здесь содержатся параметры для проверки оптимизации контента: количество слов и символов, заголовки H1-H6, изображения и уникальные хеши. Проверяется на 12 ошибок.

Если вы хотите узнать, что значит тот или иной параметр в каждом разделе, кликните по его названию и ознакомьтесь с описанием в разделе «Информация» в нижней части основного окна.

Можно выставить параметры вручную, либо же воспользоваться одним из доступных заготовленных шаблонов:

- Текущий: включает в себя все текущие параметры для открытого проекта.

- Минимум: используется, когда необходимо быстро получить список всех URL сайта и при этом минимизировать потребляемые программой ресурсы.

- По умолчанию (рекомендуемый): оптимальный набор параметров, чтобы провести полноценный аудит сайта.

- Для PageRank: шаблон параметров, необходимый для расчёта внутреннего PageRank.

- Все: включает все доступные параметры.

Теперь, когда все необходимые настройки и параметры выставлены, можно приступать к сканированию сайта.

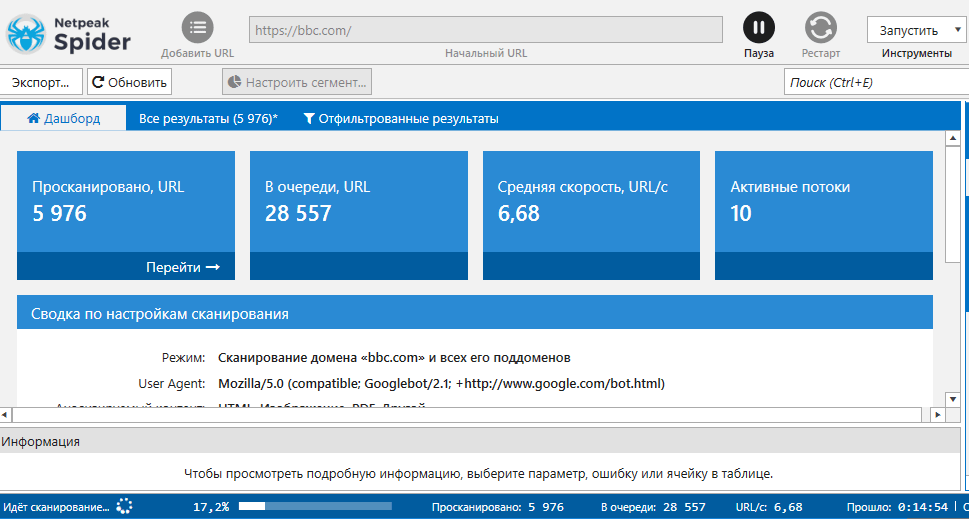

Запуск сканирования

Чтобы начать сканирование, введите в адресную строку домен сайта. Если вам нужно сканировать не весь сайт, а лишь определённые его страницы, откройте меню «Список URL» и загрузите перечень URL удобным для вас способом.

После этого нажмите кнопку «Старт».

Пока программа будет сканировать сайт, вы сможете наблюдать за процессом в режиме реального времени на вкладке «Дашборд».

На статус панели вы будете видеть скорость сканирования, сколько URL уже просканировано, сколько ещё ожидают в очереди на проверку, сколько времени прошло с момента запуска и сколько осталось (приблизительно).

Если вам понадобилось изменить настройки, а сканирование уже запущено, выполните следующие действия:

- Нажмите кнопку «Пауза».

- Внесите изменения в настройки и параметры.

- Затем снова нажмите «Старт» для возобновления краулинга.

В этом случае для ещё не просканированных URL будут учитываться новые настройки, но результаты для проверенных страниц останутся без изменений.

Если вам необходимо применить изменения ко всем URL, вместо кнопки «Пауза» воспользуйтесь кнопкой «Рестарт». Тогда программа очистит ранее полученные данные и приступит к сканированию сайта с нуля.

После завершения сканирования можно приступать к работе с результатами и отчётами.

Работа с результатами сканирования и отчётами

Рассмотрим работу с каждой из вкладок, на которых отображаются результаты сканирования.

Вкладки в основном окне программы

Дашборд

Здесь вся информация представлена в виде статистических показателей и кликабельных диаграмм.

Также на этой вкладке вы можете посмотреть количество просканированных URL, внутренних URL, страниц с критическими ошибками и индексируемых URL.

В виде диаграмм на панели приведены следующие данные:

- Индексируемость URL.

- Критичность ошибок.

- Причины неиндексируемости URL.

- Время ответа сервера.

- Код ответа сервера.

- Глубина URL.

- Статус индексации.

- Тип контента.

Все диаграммы интерактивны — кликните на любую область или значение, и все отвечающие ему URL попадут на вкладку «Отфильтрованные результаты».

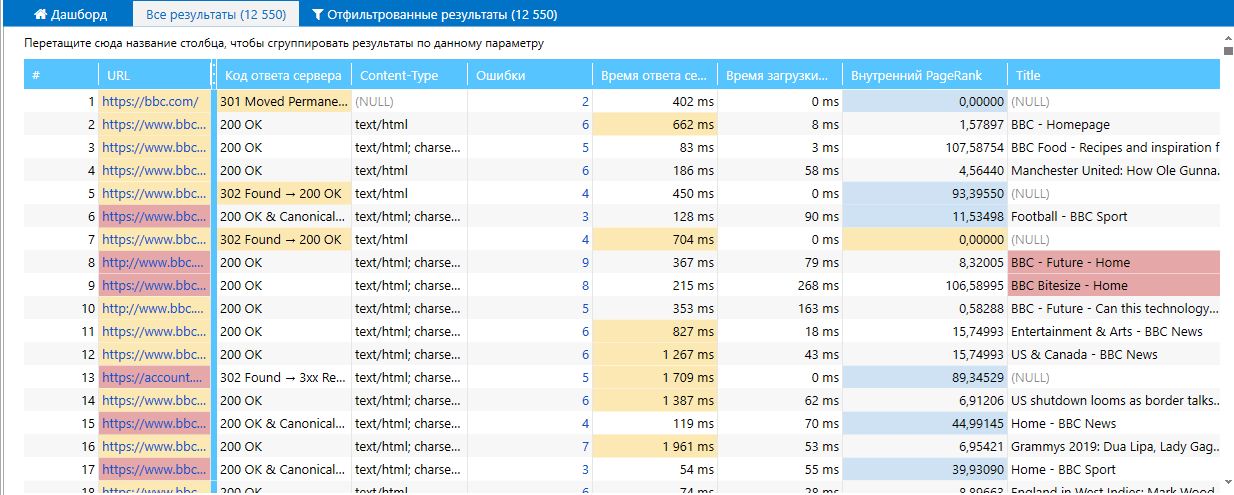

Все результаты

Здесь содержится полный список просканированных страниц, а также колонки, соответствующие выбранным параметрам сканирования.

Разный цвет ячеек в колонках говорит об уровне критичности ошибок, найденных при сканировании страниц:

- красный — высокая критичность;

- жёлтый — средняя критичность;

- синий — низкая критичность.

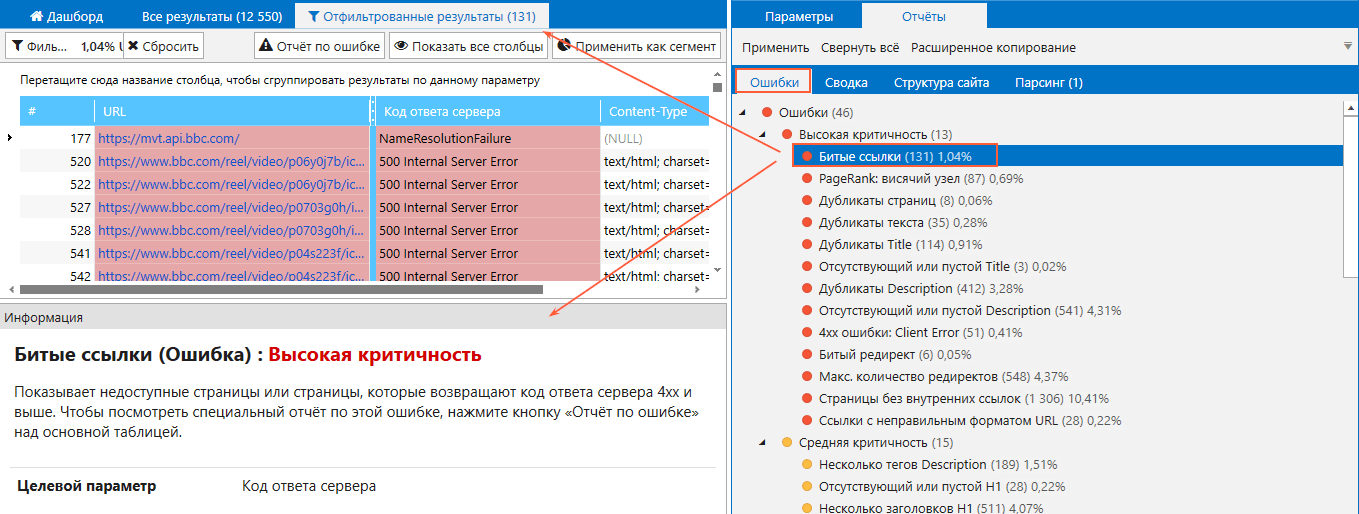

Отфильтрованные результаты

Сюда попадают страницы, которые были выделены из общего числа страниц согласно определенным параметрам. Отсортировать URL можно кликом по названию ошибки или определенному параметру на вкладке «Сводка» на боковой панели, а также при помощи пользовательской фильтрации. Нажав на кнопку «Настроить фильтр», вы сможете указывать условия, по которым будут фильтроваться URL.

Пропущенные URL

Эта вкладка появляется не всегда. В нее попадают страницы, которые не были проанализированы программой ввиду определенных факторов: например, если они закрыты от индексации, а вы выставили в настройках учет инструкций по индексации.

Причины, по которым страницы не были просканированы, отображаются над каждой отдельной группой пропущенных URL.

Вкладки с отчётами на боковой панели

Продолжая работать с результатами сканирования, переместимся на вкладку «Отчёты» на боковой панели программы, которая в свою очередь содержит ещё несколько подвкладок.

Ошибки

Здесь содержится список всех ошибок, которые программа обнаруживает в рамках каждого отдельного сканирования. Рядом с названием отображается количество URL, на которых присутствует данная ошибка и процент, который проблемные страницы составляют от общего количества.

Все ошибки разделены на три блока:

- Высокая критичность: ошибки, которые крайне пагубно сказываются на оптимизации сайта.

- Средняя критичность: ошибки, которые предупреждают об особых проблемах и требуют тщательной проверки.

- Низкая критичность: предупреждения о возможных проблемах, на которые стоит обратить внимание лишь после устранения ошибок высокой и средней критичности.

Кликнув по названию ошибки, вы окажетесь на вкладке «Отфильтрованные результаты», где будет представлен список URL с выбранной ошибкой. Также в блоке «Информация» вы увидите определение каждой ошибки.

Сводка

На этой вкладке вы увидите сводные данные по количеству страниц согласно таким параметрам:

- Статус страницы.

- Тип страницы.

- Протокол (HTTP или HTTPS).

- Хост (хосты просканированных страниц, включая поддомены).

- Код ответа сервера.

- Content-Type.

- Инструкции по индексации (robots.txt, Meta Robots и X-Robots-Tag).

- AMP HTML (страницы, у которых имеется или отсутствует AMP-версия).

- Глубина (уровень глубины страницы относительно начального URL).

Все данные на этой вкладке также кликабельны, и нажав на каждый из пунктов, вы сможете отфильтровать результаты и получить список страниц, соответствующих тем или иным параметрам.

Структура сайта

Позволяет ознакомиться со структурой сайта, которая основывается на структуре сегментов в URL. Надо заметить, что сортировка тут выполняется в два этапа — сначала по количеству точек в адресе страницы, а потом в алфавитном порядке. То есть, сканируя сайт www.example.com, с которого ведут ссылки на сайт apple.com, первым узлом будет apple.com в отчете о структуре сайта и сводке по хостам.

У последующих сегментов в URL всегда применяется сортировка по алфавиту.

Парсинг

Если в настройках вы задавали условия парсинга, его результаты отобразятся на отдельной вкладке с соответствующим названием.

Они будут условно поделены на две категории:

- Есть: список страниц, на которых в процессе сканирования были найдены данные по заданным условиям парсинга.

- Нет: список страниц, на которых соответствующие значения найдены не были.

С помощью кнопок «Все результаты» и «Показать выбранные» вы можете управлять результатами. В первом случае откроется таблица «Сводка по парсингу» со всеми URL, которые участвовали в парсинге. Во втором случае откроется таблица со списком страниц, на которых были найдены значения по заданным условиям.

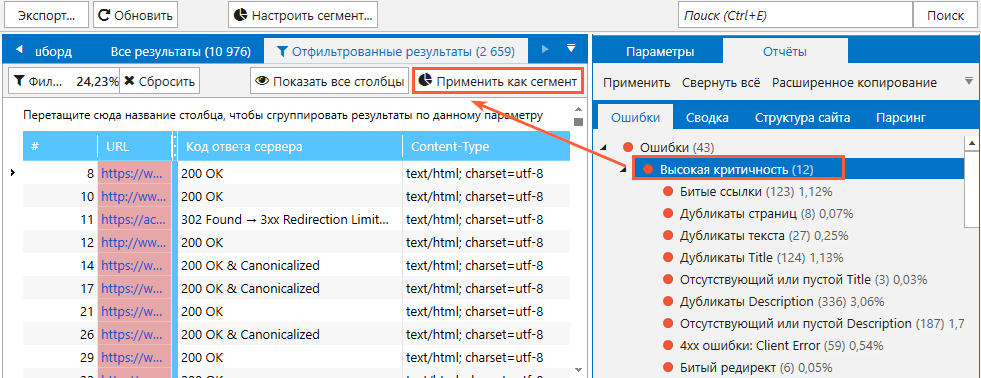

Сегменты

При работе с результатами вы можете использовать функцию «Сегменты»: подобная функция реализована в сегментах Google Analytics. Зачем это нужно? Сегменты позволяют взять любую выборку данных и отделить их от общих результатов, при этом все отчёты будут представлены только для тех страниц, которые соответствуют выборке.

Чтобы было понятнее, приведу пример. Вы хотите сосредоточиться на ошибках с высокой критичностью и получить отчёты исключительно по ним. Для этого необходимо:

- Кликнуть на пункт «Высокая критичность» на вкладке с ошибками.

- Открыть «Отфильтрованные результаты» и в правом верхнем углу таблицы нажать кнопку «Применить как сегмент».

После этого вся статистика и все отчёты будут формироваться только для URL, принадлежащим данному сегменту.

В качестве сегмента можно применить любые условия, которые позволяют отфильтровать результаты сканирования.

Также сегментацию можно настроить вручную с помощью кнопки «Настроить сегмент». Принцип работы идентичен тому, что используется для настройки фильтра.

База данных

Для работы с результатами вам также будет полезен модуль «База данных». С помощью него вы можете в отдельном окне просмотреть специальные отчёты по следующим данным:

- Входящие и исходящие ссылки.

- Изображения.

- Ошибки.

- Редиректы.

- Атрибут Canonical.

- Заголовки H1-H6.

- Результаты парсинга.

Важно отметить, что отчёты вы увидите в том случае, если соответствующие параметры сканирования учитывались в процессе анализа.

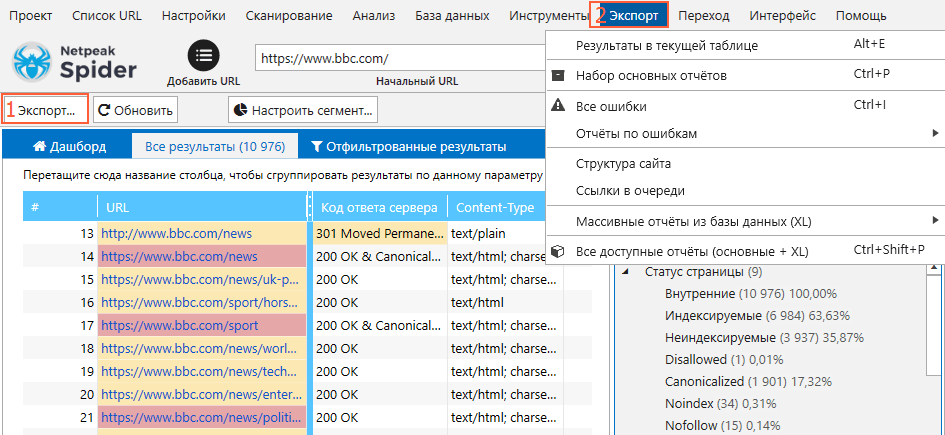

Сохранение проекта и выгрузка данных

Чтобы не терять полученные данные после завершения сканирования и закрытия программы, в ней предусмотрено сохранение проектов. Так вы сохраните не только результаты сканирования, но также отчёты и все установленные вами настройки, и сможете вернуться к ним в любой момент. Чтобы сохранить проект, в основном окне откройте пункт меню «Проект» и выберите «Сохранить».

При необходимости выгрузить отчёты и данные из таблиц воспользуйтесь функцией «Экспорт». Кнопка в левом верхнем углу отвечает за экспорт текущей таблицы.

Для экспорта отдельных отчётов откройте раздел меню «Экспорт» и выберите нужный тип отчета.

Данные выгружаются и сохраняются в двух форматах: .CSV и .XLSX. Каким из них воспользоваться — выбирать вам.

Вот так, к примеру, выглядит отчёт формата .XSLS по ссылкам с неправильным форматом URL, который мы выгрузили через меню «Экспорт».

Обратите внимание, что в отчётах формата .XLSX сохраняется подсветка ячеек и описание параметров — как в таблице самой программы.

Встроенные инструменты Netpeak Spider

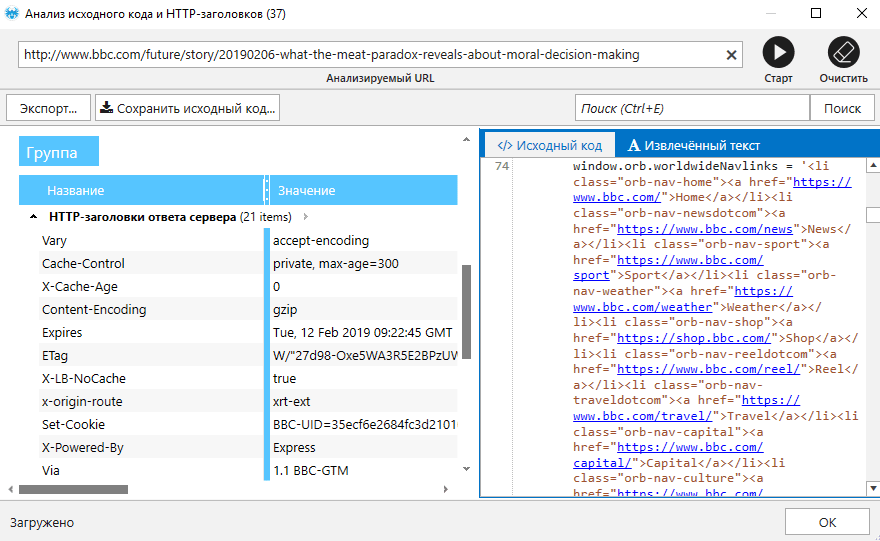

Анализ исходного кода и HTTP-заголовков

Название инструмента говорит само за себя — с его помощью вы можете посмотреть:

- исходный код страницы;

- общие данные о странице, полученные при обращении к URL;

- данные об HTTP-заголовках запроса и ответа сервера;

- список GET-параметров, если они присутствуют в URL.

Просматривать исходный код можно не только у HTML-страниц, но и у файлов JavaScript, XML и GZIP.

На вкладке «Извлечённый текст» вы можете увидеть весь контент страницы без HTML-тегов. Функция помогает понять, как именно программа анализирует текст при расчётах количества слов или символов на странице.

Это также объясняет почему иногда данные в самой программе отличаются от тех, которые вы видите в браузере при посещении сайта.

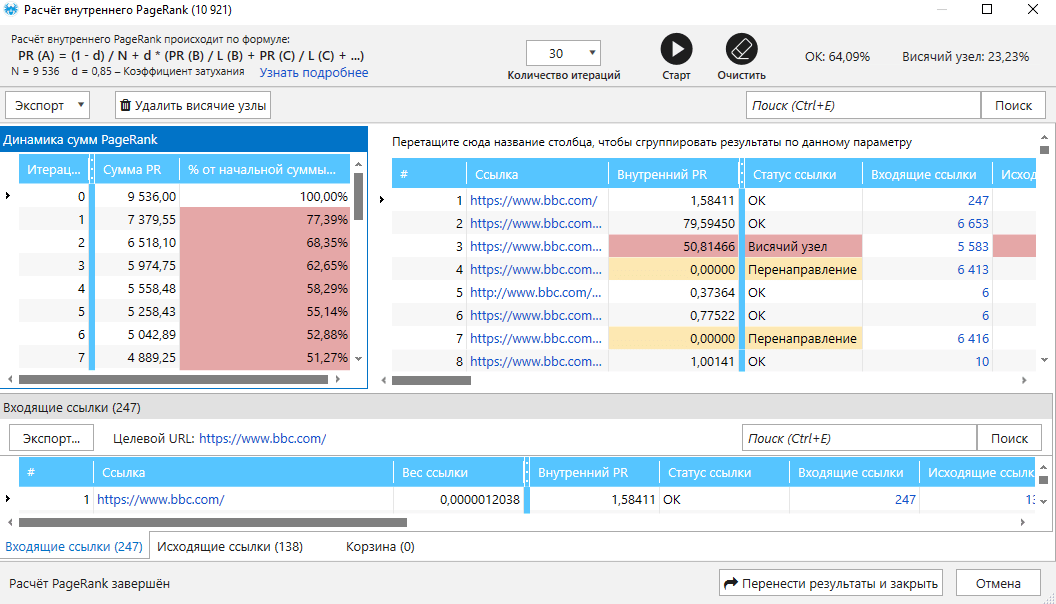

Расчет внутреннего PageRank

Это уникальный инструмент, с помощью которого вы можете узнать, как по сайту распределяется ссылочный вес. Так вы можете узнать о страницах, которые получают недостаточно ссылочного веса или наоборот получают его в переизбытке, а также увидите, какие из страниц могут оказаться недосягаемыми для поисковых роботов. Инструмент будет полезен для анализа и улучшения внутренней перелинковки на сайте.

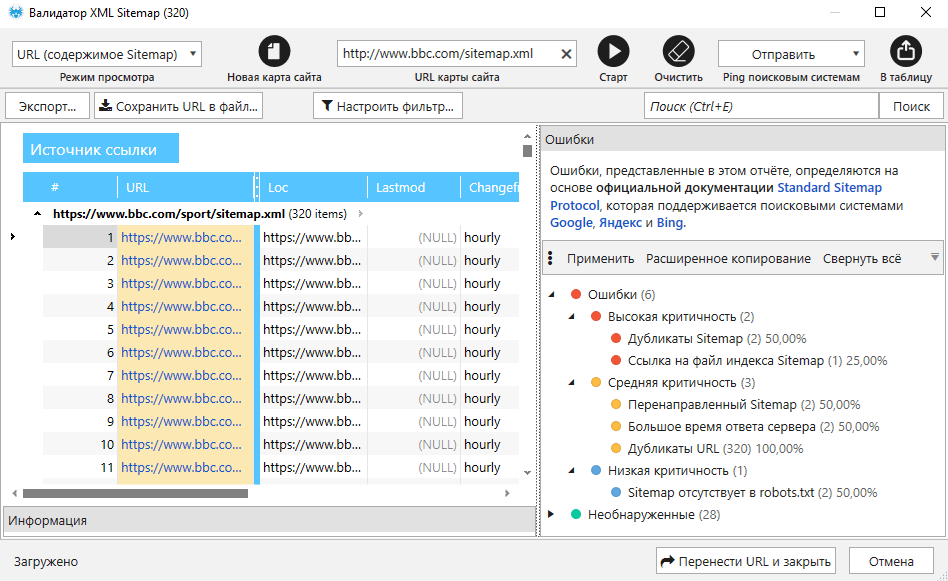

Валидатор XML Sitemap

Это инструмент позволяет:

- проверять карту сайта на ошибки разного уровня критичности;

- анализировать ссылки в карте сайта с возможностью перенести их в основную таблицу и просканировать;

- отправлять ping поисковым системам, чтобы сообщить им об изменениях в карте сайта.

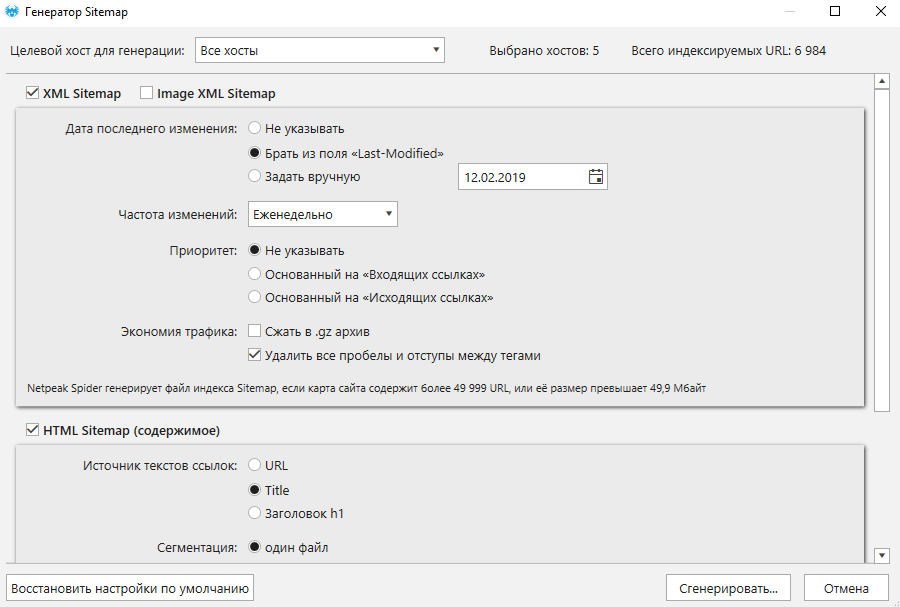

Генератор Sitemap

Инструмент позволяет в несколько кликов создать различные файлы Sitemap: XML Sitemap, Image Sitemap, HTML Sitemap и TXT Sitemap.

Генерируя карту сайта, вы можете выбрать разные настройки для каждой из разновидностей карт.

Подводим итоги

Netpeak Spider — краулер, который проводит обширный SEO-аудит с высокой скоростью сканирования, находит ошибки, препятствующие поисковому продвижению и формирует по ним детальные отчёты.

Благодаря своему функционалу программа справляется с такими задачами, как парсинг, анализ структуры сайта, создание карт сайта, расчёт внутреннего PageRank и многими другими. Помимо прочего, краулер имеет ряд конкурентных преимуществ, среди которых:

- Оптимальное потребление оперативной памяти.

- Управление параметрами сканирования.

- Функция сегментации данных.

- Комплексный анализ структуры сайта.

- Кастомная фильтрация результатов.

- Адаптивный дашборд.

- Быстрый экспорт любых данных.

Netpeak Spider обеспечивает максимально удобное и эффективное выполнение важных задач в работе специалистов по SEO. Читатели Лидзавода могут приобрести данный инструмент со скидкой по промокоду.