Резкий скачок конверсии не отражается на продажах? А может, его просто не существует? Если основывать решения на ложных итогах теста, в лучшем случае вы упускаете шанс оптимизации, в худшем – снижаете конверсию.

К счастью, есть способ это предотвратить. Что такое A/A тестирование, как его провести – читайте в статье.

- Ложноположительный результат

- A/A vs A/B

- Пример 1. Как страница может переиграть своего клона

- Пример 2. Как ничего не делать и повысить конверсию на 300%

- Стоит ли проводить A/A тесты

- A/A/B vs A/A

- Заключение

Ложноположительный результат

Допустим, вы оцениваете комбинации кнопки и заголовка. Когда достоверность достигает 99%, делаете выводы и применяете на практике.

Через несколько бизнес-циклов наблюдаете: обновленный дизайн не приносит ожидаемой прибыли. А ведь вы проводили тестирование, вкладывали в него время и ресурсы!

Это ложноположительный результат, известный также, как «статистическая ошибка первого типа» и «ошибочное отклонение верной нулевой гипотезы». Он встречается чаще, чем вы думаете – примерно в 80% случаев.

Почему это происходит?

Эффект инструмента

В начале эксперимента важно убедиться, что конфигурация инструмента правильная и он работает как надо. Иначе – риск получить:

- Неверные показатели. Всего одна ошибка может исказить данные A/B тестирования. Как минимум, интегрируйте с Google Analytics для перепроверки.

- Неверное отображение посадочной страницы. Убедитесь, что лендинги выглядят корректно на всех устройствах и браузерах, и посетители не сталкиваются с фликкер-эффектом. Медленная работа сайта вызывает эту же проблему.

- Преждевременное завершение теста. Иногда софт объявляет «победителя» слишком рано – при недостаточных размере или репрезентативности выборки. Помните: если вы достигли статистической значимости, это не значит, что пора прекращать тест. Чем он дольше, тем точнее результаты.

Смотрите в оба: любые из этих признаков ведут к ложному выводу. Отслеживайте каждую цель и метрику. Если какой-либо показатель не фиксируется (например, добавления товара в корзину), остановите тест, устраните проблему, и начните снова.

A/A vs A/B

A/B тест пригоняет трафик на контрольную версию и вариацию и показывает, какая работает лучше.

A/A – то же самое, только для двух одинаковых страниц. Цель – не увидеть различий в их показателях.

Только 20% экспериментов дают достоверные результаты. Статистической значимости и большой репрезентативной выборки недостаточно. Поэтому профессионалы используют эту технику до A/B теста.

Как видите, эти типы дополняют друг друга.

Если в конце эксперимента показатели конверсии обеих страниц совпадают, можно запускать A/B тест. На практике не всегда все проходит гладко.

Пример 1. Как страница может переиграть своего клона

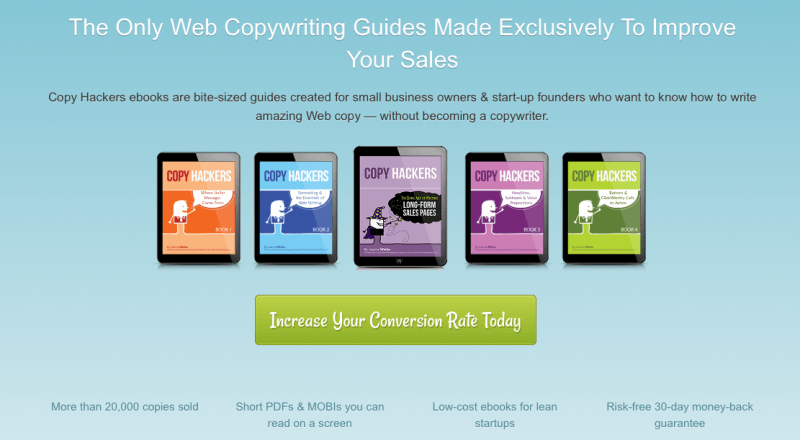

Это лендинг, который тестировала команда Copyhackers в ноябре 2012 года:

Через 6 дней система тестирования отметила «победивший» вариант при уровне достоверности 95%. Ради точности эксперимент продлили на день – и достигли 99,6% точности:

Страница на 24% эффективнее, чем точно такая же? Результат ложноположительный. Еще через 3 дня различия исчезли:

Вывод: тест слишком рано вычислил победителя.

Пример 2. Как ничего не делать и повысить конверсию на 300%

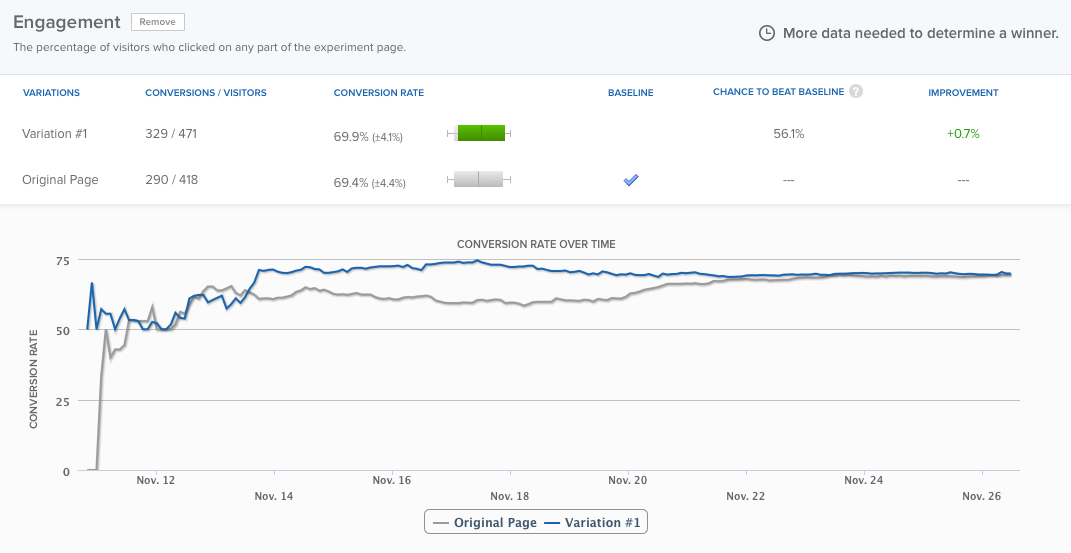

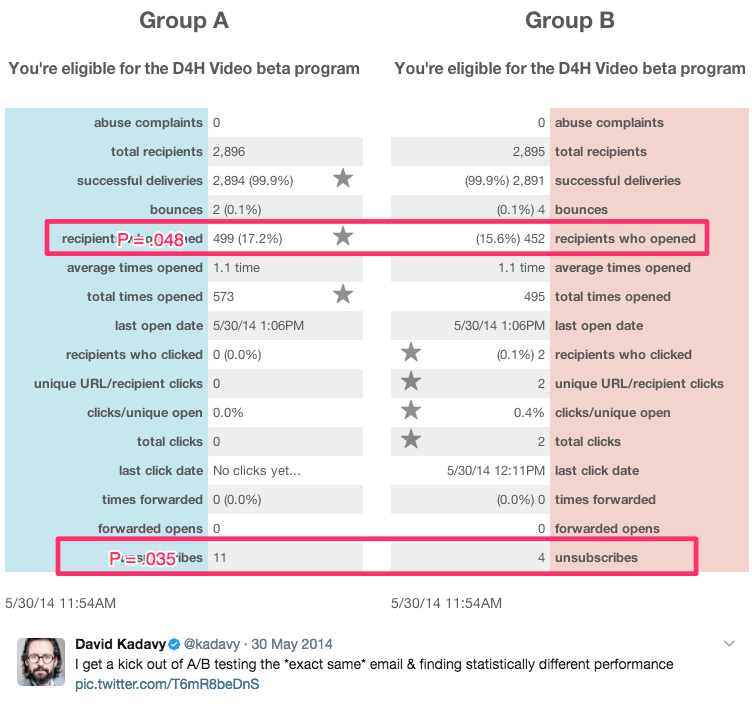

Автор этого саркастического заголовка – Дэвид Кадави, который 8 месяцев применял A/A тесты на 750,000 подписчиков. Например, он получил такие статистически значимые данные:

Что мы видим:

- 9% – рост показателя открытия писем;

- На 300% выросло количество переходов по ссылкам;

- На 51% упал показатель отписок от рассылки.

И все бы ничего, но это A/A тест! Контент, который конкурирует друг с другом, абсолютно идентичный.

Стоит ли проводить A/A тесты

Известный эксперт Нил Патель наблюдал большие скачки конверсии без увеличения выручки. Он советует первым делом тестировать софт, чтобы потом не расхлебывать последствия неверных решений.

По мнению Пипа Лайя, основателя агентства ConversionXL, тесты сами по себе трата времени.

Кому верить? С одной стороны, точность превыше всего, и метод A/A – способ ее обеспечить. С другой – трата ресурсов на тестирование, а также подготовку к нему.

Крейг Салливан, эксперт по пользовательскому опыту, считает, что 40 тестов в месяц – высокая нагрузка для сотрудников. Лучше убить полдня на QA, чем 2-4 недели на то, чтобы просто проверить работу инструмента.

Проблема №1. A/A тесты занимают время и трафик, которые вы можете потратить на изучение поведения посетителей сайта.

Проблема №2. И A/B, и A/A нужно тщательно организовывать и мониторить, чтобы не получить ложный результат. Как в примере от Copyhackers.

Потратить время или рискнуть надежностью ПО при принятии решения – решать вам.

Есть потенциально менее затратный вариант – A/A/B.

A/A/B vs A/A

Традиционное A/A тестирование ничего не говорит о посетителях. Но если добавить в процесс еще вариант – другое дело.

A/A = конкурируют 2 одинаковые страницы.

A/A/B = A/A тест + одна дополнительная вариация.

Вы поймете, стоит ли доверять инструменту. Если да, выбираете лучшую версию в соответствии с его показаниями. Если нет, их не стоит применять.

Да, нужно больше времени, чтобы достичь статистической значимости. Зато вы оцениваете и софт, а если он подтвердит свою надежность, – и поведение посетителей.

Заключение

Перевешивают ли выгоды A/A тестирования его недостатки? Нет однозначного ответа. Проводить тестирование ежемесячно – лишнее. Достаточно – при использовании нового софта (сервиса для проведения тестов). Для тех, кому совсем жалко времени, есть компромиссный вариант – A/A/B тест.

Если вы исключите ошибки сегодня, получите более точные итоги в будущем.

Высоких вам конверсий!

Статья подготовлена по материалам instapage.com.

Источник: Yagla